O que são memórias HBM (High Bandwidth Memory)?

Entenda como essa tecnologia revoluciona GPUs, inteligência artificial e computação de alto desempenho

Quando falamos em desempenho extremo para GPUs, data centers, inteligência artificial e aplicações científicas, não basta apenas ter um processador gráfico poderoso. A memória utilizada é um fator decisivo — e é exatamente nesse ponto que entram as memórias HBM (High Bandwidth Memory).

Essa tecnologia foi criada para resolver gargalos de largura de banda e eficiência energética, permitindo que grandes volumes de dados sejam acessados com muito mais rapidez. Neste guia, você vai entender o que é a memória HBM, como ela funciona, suas vantagens e onde ela é usada atualmente.

O que é memória HBM?

HBM (High Bandwidth Memory) é um tipo de memória RAM de altíssimo desempenho, projetada para oferecer uma largura de banda muito superior às memórias GDDR tradicionais, como GDDR6 e GDDR6X, amplamente usadas em placas de vídeo convencionais.

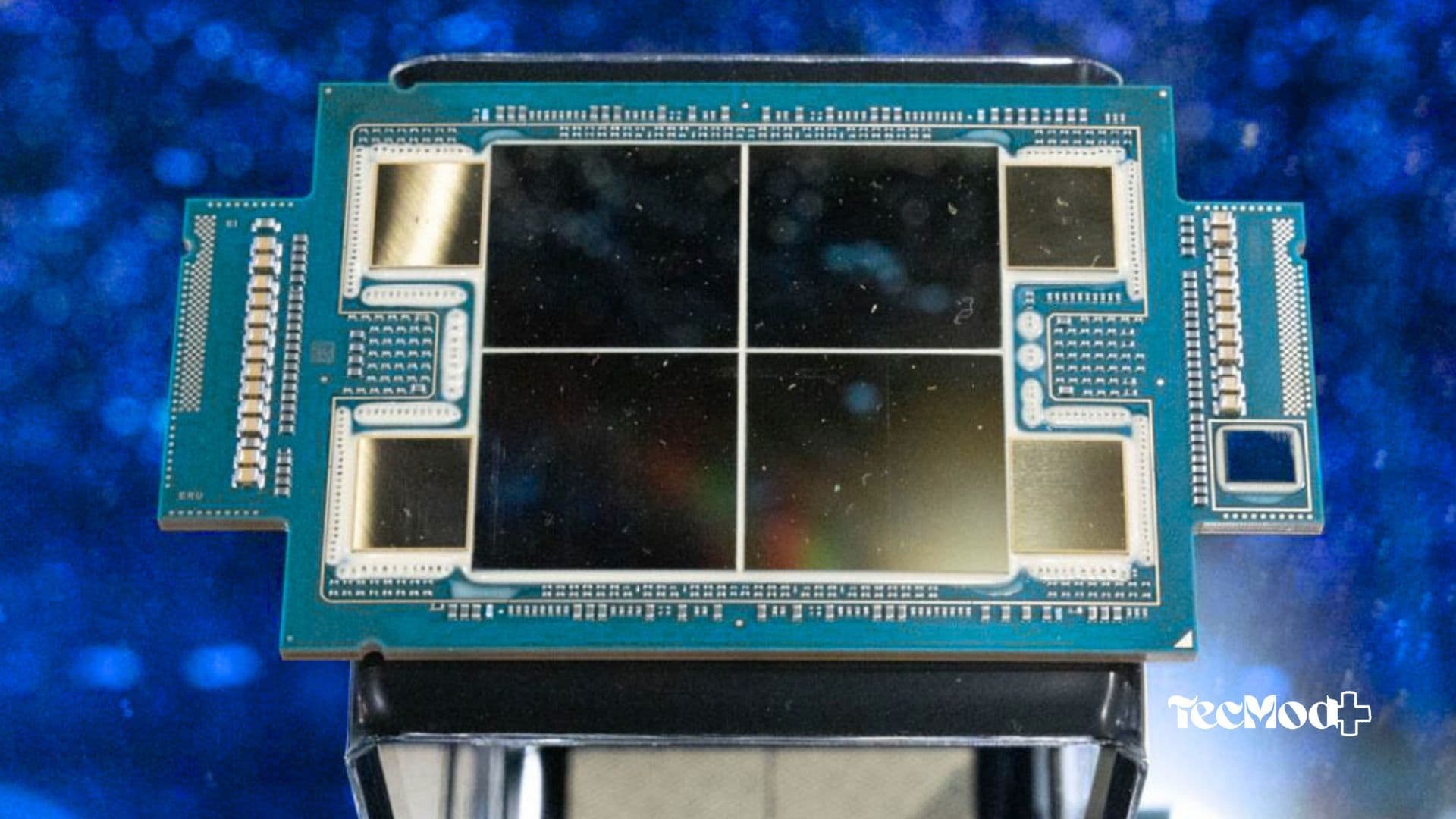

Ela foi desenvolvida inicialmente pela AMD em parceria com a SK Hynix e apresentada ao mercado em 2015. A grande diferença está na sua arquitetura: enquanto a GDDR fica posicionada ao redor da GPU, a HBM é empilhada verticalmente (3D) e instalada muito próxima ao chip gráfico.

Essa proximidade reduz drasticamente a distância que os dados percorrem, garantindo mais velocidade, menor latência e maior eficiência energética.

Como a memória HBM funciona?

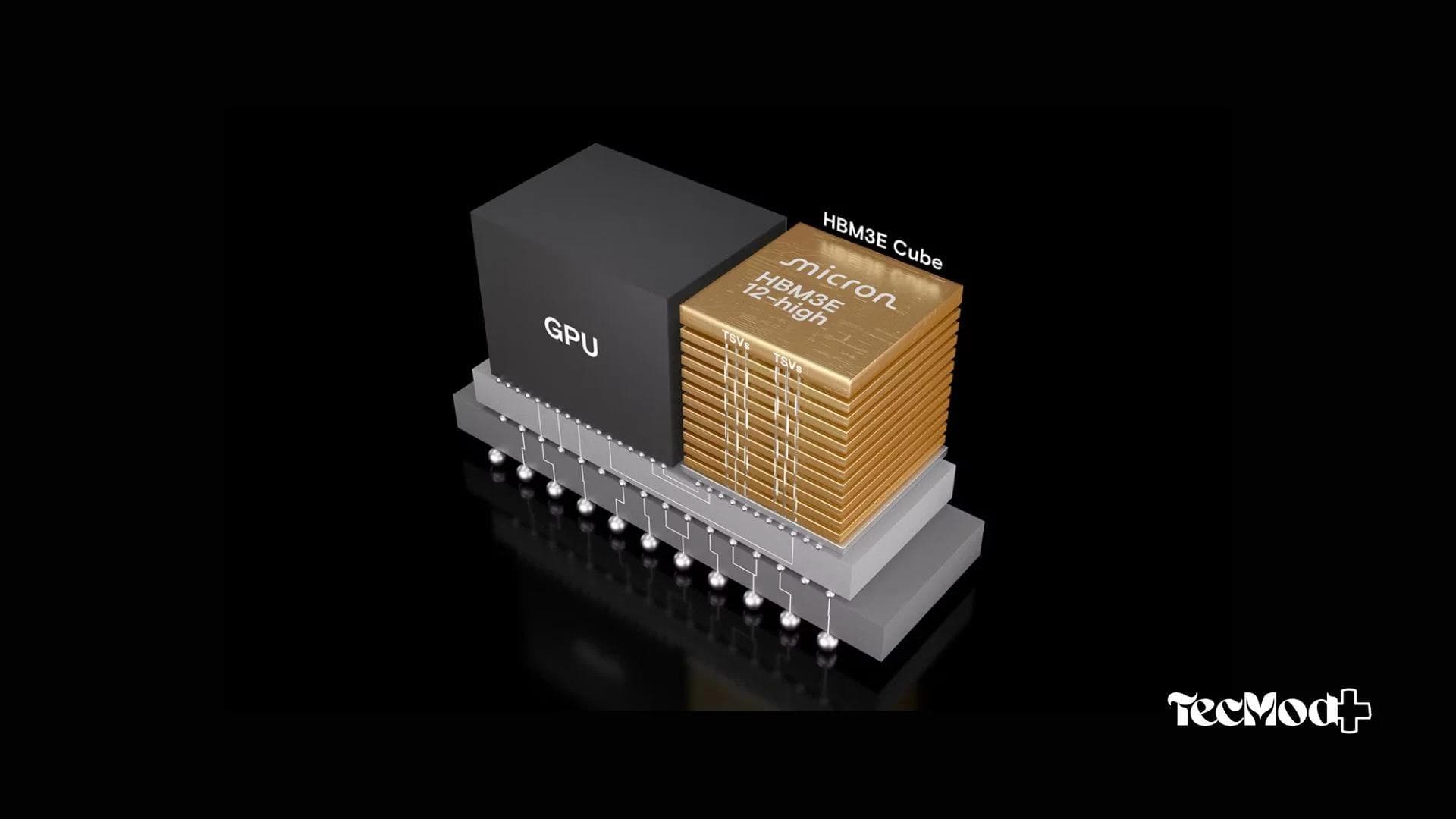

A arquitetura da HBM é baseada em pilhas verticais de chips DRAM, que podem conter até 8 ou mais camadas (dies). Essas pilhas são conectadas à GPU por meio de um interposer de silício, que funciona como uma base intermediária de comunicação de alta velocidade.

As conexões internas utilizam TSVs (Through-Silicon Vias), que permitem a comunicação direta entre as camadas de memória, eliminando gargalos comuns em arquiteturas tradicionais.

Gerações da memória HBM

Com o avanço das demandas computacionais, a HBM evoluiu rapidamente. Cada geração trouxe melhorias significativas em largura de banda, densidade e eficiência.

HBM1 – O início da largura de banda extrema

Lançada em 2013, a HBM1 foi o primeiro grande passo além das memórias GDDR. Cada stack oferecia até 128 GB/s, com até 4 camadas de DRAM empilhadas.

Apesar da adoção limitada, foi essencial para pavimentar o caminho da tecnologia, sendo usada em GPUs como a AMD Radeon Fury X.

HBM2 – Mais desempenho e eficiência

A HBM2, lançada em 2016, elevou o patamar ao oferecer até 256 GB/s por stack, com até 8 GB de capacidade por pilha. Essa geração se tornou comum em GPUs profissionais voltadas para data centers, ciência e renderização, como as Nvidia Tesla e AMD Radeon Instinct.

HBM2E – Otimizada para IA e HPC

A HBM2E trouxe melhorias adicionais, alcançando até 460 GB/s por stack e até 16 GB por pilha. Ela é amplamente utilizada em aceleradores de inteligência artificial, como a Nvidia A100, sendo ideal para machine learning, deep learning e HPC.

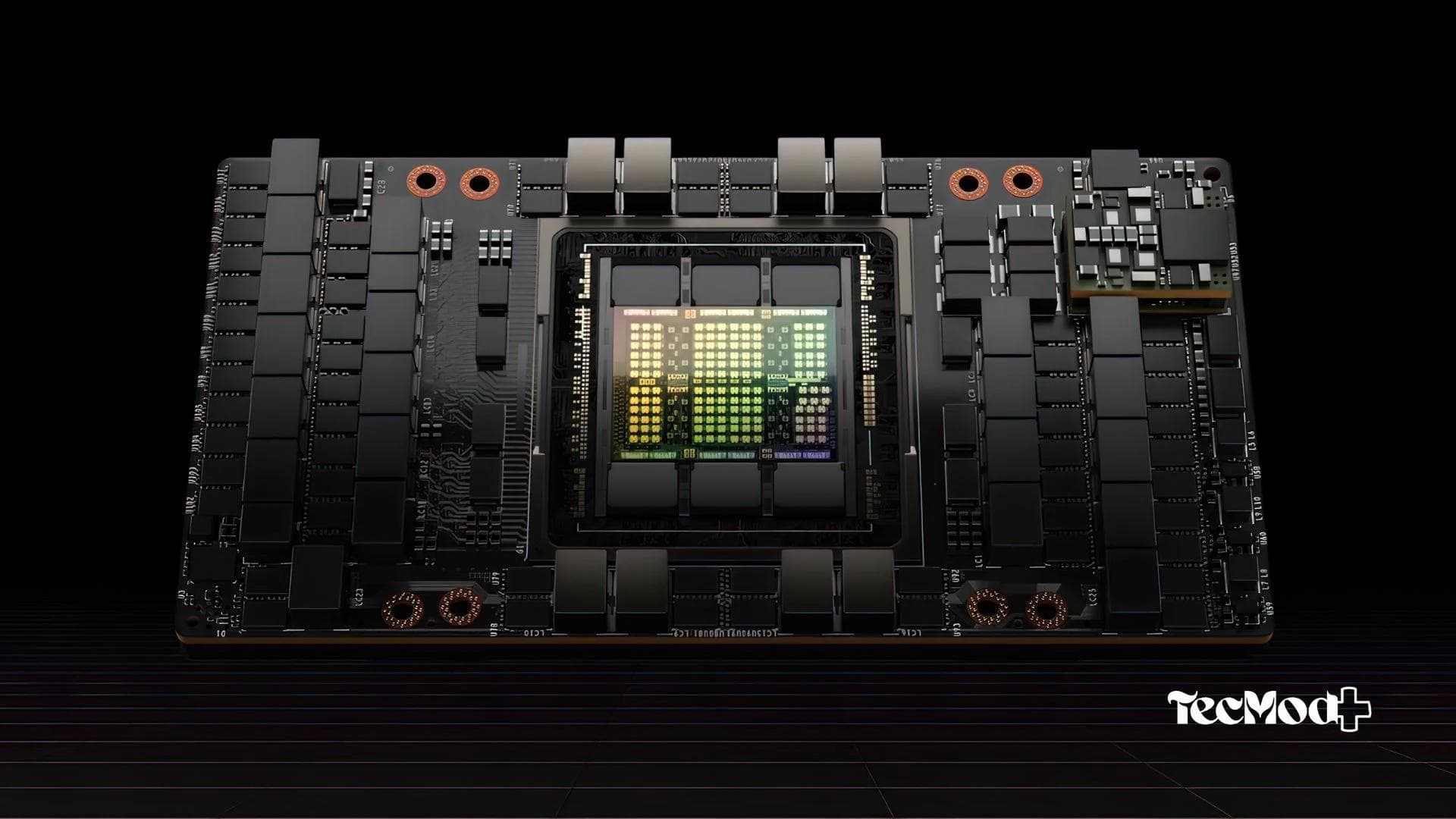

HBM3 – O padrão para IA generativa

A HBM3, anunciada em 2022, representa o estado da arte da tecnologia. Cada stack pode alcançar até 819 GB/s, permitindo sistemas com mais de 1 TB/s de largura de banda total.

Presente em GPUs como Nvidia H100 e AMD MI300X, essa geração foi projetada para cargas extremamente paralelas, como modelos de linguagem (LLMs), IA generativa e simulações em larga escala.

Principais vantagens da memória HBM

As memórias HBM oferecem benefícios claros em relação às tecnologias convencionais:

- Altíssima largura de banda: soluções com HBM podem ultrapassar 1 TB/s, superando amplamente a GDDR6.

- Maior eficiência energética: menos consumo por bit transferido, ideal para data centers.

- Menor espaço físico: design compacto graças ao empilhamento vertical.

- Latência reduzida: comunicação direta com a GPU melhora a resposta em cargas intensas.

Onde a memória HBM é utilizada?

Devido ao custo elevado, a HBM é mais comum em ambientes profissionais:

- GPUs para workstations e data centers, como Nvidia A100, H100 e AMD Instinct.

- Supercomputadores e HPC, usados em pesquisa científica e simulações complexas.

- Inteligência artificial, especialmente IA generativa e deep learning.

- Gaming (casos específicos), como AMD Radeon Fury X e Vega, sem adoção em massa.

Vale a pena investir em uma GPU com HBM?

Se você trabalha com IA, renderização 3D pesada, simulações científicas ou ciência de dados, a resposta é sim. A memória HBM reduz gargalos críticos e permite que o hardware opere no máximo do seu potencial.

Essas GPUs, porém, são focadas em workstations e servidores profissionais, não no consumidor comum.

Conclusão

A memória HBM representa um dos maiores avanços na arquitetura de GPUs e sistemas de alta performance. Com largura de banda massiva, menor consumo energético e baixa latência, ela se tornou essencial para aplicações modernas de inteligência artificial, ciência de dados e computação avançada.

Para quem busca desempenho profissional sem compromissos, GPUs com HBM aliadas a uma workstation bem configurada são hoje a melhor escolha.

Confira também: O que é HPC e como funciona a computação de alto desempenho

Relacionados

Guia Tech

Guia TechO que é o n8n e como ele pode automatizar suas tarefas

Guia Tech

Guia TechCibersegurança em 2026: ameaças digitais, IA, deepfakes e o novo papel do suporte de TI

Guia Tech

Guia TechGolpes Digitais Mais Comuns no Brasil em 2026: Como Funcionam e Como se Proteger

Compartilhe este post

Fique por dentro do mundo Tech

Receba as últimas novidades, tutoriais exclusivos e análises de gadgets diretamente na sua caixa de entrada. Sem spam, apenas conteúdo de qualidade.

Ao se inscrever, você concorda com nossa Política de Privacidade.

Comentários

Carregando comentários...

Relacionados

Guia Tech

Guia TechGuia Prático de Zero Trust: o que é, como funciona e como implementar

Guia Tech

Guia TechHuawei: Entre a Liderança Tecnológica e o Furacão das Polêmicas

Guia Tech

Guia TechProgramação com IA: o que a inteligência artificial realmente faz (e o que ainda depende de você)

Guia Tech

Guia TechGems do Gemini: o que são e como criar seus próprios assistentes de IA

Guia Tech

Guia TechO que são prompts em IA? Guia completo para criar comandos poderosos

Guia Tech

Guia Tech